梅河口市中心医院服务器数据恢复采购项目投标方案

第一章 项目整体服务方案

6

第一节 数据恢复方案

6

一、 22TB数据恢复策略

6

二、 文件名文件夹对应方案

23

三、 数据对接计划制定

28

四、 服务器设备配置方案

40

第二节 系统问题解决方案

52

一、 磁盘挂载问题处理

52

二、 HA双机热备优化

59

三、 故障转移IP配置

64

四、 RedHat7.6系统保障

68

五、 FTP服务异常恢复

83

第三节 数据库监测机制

90

一、 运行状态监测方案

90

二、 实时监控工具配置

102

三、 健康评估报告体系

123

第四节 软件版本升级计划

129

一、 HA双机热备升级

129

二、 FTP服务升级方案

142

三、 操作系统升级规划

160

四、 升级后功能验证

176

第五节 问题预警机制建立

194

一、 系统异常预警指标

194

二、 自动化监控平台配置

205

三、 应急响应处理流程

211

第二章 服务保密方案及措施

223

第一节 技术和操作保密措施

223

一、 封闭环境操作管控

223

二、 数据访问权限分级

235

三、 操作日志记录审计

240

四、 技术文档处理规范

254

第二节 公司保密管理制度

258

一、 保密协议签订管理

258

二、 保密信息流转控制

270

三、 保密管理责任体系

287

四、 保密培训教育计划

297

第三节 信息安全管理制度

302

一、 安全事件应急响应

302

二、 数据加密存储策略

313

三、 安全风险评估机制

319

四、 数据传输安全保障

330

第四节 终端设备管理制度

341

一、 设备登记备案管理

341

二、 终端安全软件部署

349

三、 外接设备使用限制

370

四、 设备数据擦除规范

378

第五节 信息系统与设备保密制度

386

一、 系统隔离防护措施

386

二、 访问控制策略配置

397

三、 服务器安全加固方案

413

四、 系统日志审查机制

424

第三章 项目质量保障方案及措施

429

第一节 质量保障目标分析

429

一、 数据恢复一致性保障

429

二、 恢复过程可追溯性

440

三、 系统运行稳定性目标

458

第二节 质量管理体系建立

478

一、 项目团队责任机制

478

二、 标准化操作流程制定

495

三、 质量监督管理体系

500

第三节 质量保障措施实施

508

一、 专业工具设备配置

508

二、 数据安全保障措施

531

三、 数据完整性校验实施

544

第四节 质量控制流程制定

566

一、 全过程质量控制设计

566

二、 数据恢复流程控制

582

三、 质量回溯与改进机制

590

第五节 质量评审实施计划

610

一、 阶段性质量评审安排

610

二、 最终质量验收评审

629

第四章 应急处理方案

643

第一节 数据安全应急处置流程

643

一、 PACS服务器应急处置流程制定

643

二、 数据完整性验证机制建立

656

三、 数据恢复备用方案设计

673

第二节 突发情况影响评估机制

678

一、 突发情况识别与分类

678

二、 影响评估模型构建

698

三、 风险预警与响应策略

709

第三节 应急服务实施计划制定

721

一、 应急响应组织架构搭建

721

二、 全天候应急响应机制建立

736

三、 应急资源配置与演练安排

760

第四节 应急质量保证措施

775

一、 应急处理质量控制流程

775

二、 数据恢复完整性保障

790

三、 客户验收确认机制

808

第五章 投标技术指标

813

第一节 技术参数响应方案

813

一、 核心技术参数响应

813

二、 技术证明材料提供

818

三、 系统环境兼容性

830

第二节 设备配置匹配方案

843

一、 数据恢复服务器配置

843

二、 设备现场部署计划

854

三、 设备运行测试方案

870

第三节 技术履约保障措施

890

一、 履约团队配置

890

二、 技术实施流程

904

三、 技术验收标准

914

四、 技术风险应对

930

五、 履约时间计划

944

第六章 数据备份和恢复演练方案

954

第一节 数据备份策略制定

954

一、 备份频率规划

954

二、 数据备份范围界定

964

三、 备份介质管理规范

970

四、 备份数据加密机制

991

第二节 备份任务执行方案

1008

一、 备份执行流程设计

1008

二、 自动化执行方案构建

1025

三、 失败重试与告警机制

1036

四、 执行情况审查机制

1053

第三节 备份结果检查和恢复演练

1064

一、 备份结果验证流程

1064

二、 恢复演练计划制定

1079

三、 恢复演练操作规范

1085

四、 演练报告与优化机制

1101

第七章 售后服务

1110

第一节 售后服务内容

1110

一、 定期远程巡检服务

1110

二、 技术支持与故障处理

1127

第二节 服务方式与响应能力

1141

一、 远程与现场服务结合

1141

二、 服务响应有效性保障

1158

第三节 响应时间要求

1181

一、 工作时间响应标准

1181

二、 非工作时间响应机制

1197

三、 重大数据异常应急措施

1216

第四节 技术支持服务

1228

一、 系统运行维护指导

1228

二、 数据恢复后培训服务

1245

三、 文档与技术支持

1262

四、 系统优化与备份服务

1276

项目整体服务方案

数据恢复方案

22TB数据恢复策略

恢复技术选型标准

先进数据恢复技术

专业数据扫描技术

采用专业的数据扫描技术,对存储设备进行全面且深入的扫描,能够精准定位数据的存储位置。即便数据处于损坏或丢失状态,也能尽可能地识别和提取出来。利用智能算法对扫描结果进行细致分析,准确判断数据的完整性和可恢复性,为后续的数据恢复工作提供科学、可靠的依据。该技术支持多种存储介质和文件系统的扫描,可确保在不同的硬件环境下,都能高效地开展数据恢复工作。同时,通过优化扫描算法和流程,提高扫描的速度和准确性,减少不必要的时间和资源浪费。

专业数据扫描技术

无损数据提取技术

运用无损数据提取技术,在恢复数据的过程中,最大程度地保证数据的原始性和完整性,避免因恢复操作对数据造成二次损坏。对于受损严重的数据块,采用特殊的修复和提取方法,充分利用数据的冗余信息和关联关系,尝试恢复出可用的数据。通过数据加密和校验机制,确保提取的数据在传输和存储过程中的安全性和准确性。在提取数据时,对数据进行实时监测和验证,确保提取的数据符合原始数据的特征和要求。

无损数据提取技术

高效数据修复技术

针对出现“超级坏块”等错误的数据,采用高效的数据修复技术,对损坏的数据进行修复和重建。利用先进的算法对数据进行分析和处理,识别和纠正数据中的错误和损坏部分,提高数据的可用性。支持对多种类型的数据错误进行修复,包括文件系统损坏、数据丢失、数据损坏等,确保数据能够正常使用。在修复过程中,不断优化修复算法,提高修复的成功率和效率,减少修复时间和成本。

适配现有环境技术

系统兼容性技术

确保所选的数据恢复技术与现有的服务器操作系统(RedHat7.6)具有良好的兼容性,避免因技术不兼容而导致数据恢复失败。对技术进行严格的兼容性测试,在不同的系统环境下进行模拟恢复操作,验证技术的稳定性和可靠性。根据系统的特点和要求,对技术进行优化和调整,确保其能够在现有系统中高效运行。同时,与操作系统的供应商保持密切沟通,及时获取系统更新和补丁,保证技术与系统的兼容性。

硬件适配技术

保证数据恢复技术能够与现有的两台物理服务器硬件设备相适配,包括服务器的处理器、内存、硬盘等硬件组件。根据硬件的性能和特点,合理调整技术的参数和配置,充分发挥硬件的优势,提高数据恢复的效率。对硬件设备进行实时监测和评估,及时发现和解决硬件与技术之间的兼容性问题。定期对硬件设备进行维护和保养,确保硬件设备的正常运行。

网络适配技术

使数据恢复技术能够适应现有的网络环境,确保数据在恢复过程中的传输稳定和高效。优化技术的网络传输协议和算法,减少网络延迟和数据丢包的情况,提高数据传输的速度和质量。支持多种网络拓扑结构和网络带宽,确保在不同的网络条件下都能顺利完成数据恢复工作。同时,对网络环境进行实时监测和优化,及时解决网络故障和问题,保证数据传输的稳定性。

设备资源保障

数据安全保障技术

数据加密技术

在数据恢复过程中,采用高强度的数据加密技术对数据进行加密处理,确保数据在传输和存储过程中的安全性。使用先进的加密算法,如AES、RSA等,对数据进行加密,防止数据被窃取或篡改。对加密密钥进行严格的管理和保护,确保只有授权人员能够访问和使用加密数据。同时,定期更新加密密钥,提高数据的安全性。

数据备份技术

在恢复数据的同时,对重要的数据进行实时备份,防止因意外情况导致数据再次丢失。采用多种备份方式,如本地备份、异地备份等,确保数据的安全性和可靠性。定期对备份数据进行检查和验证,确保备份数据的完整性和可用性。在备份过程中,对备份数据进行加密处理,提高备份数据的安全性。

访问控制技术

建立严格的访问控制机制,对数据恢复过程中的访问权限进行严格管理,确保只有授权人员能够访问和操作数据。采用身份认证、授权管理等技术手段,对用户的身份和权限进行验证和管理,防止非法访问和数据泄露。对访问记录进行详细的审计和监控,及时发现和处理异常访问行为。同时,定期对访问控制机制进行评估和优化,提高访问控制的有效性。

数据操作流程设计

数据预处理流程

数据评估

对存储设备进行全面检测,评估数据损坏程度。通过专业的检测工具和技术,对存储设备的物理状态、文件系统结构等进行详细检查,准确判断数据的损坏情况。分析数据丢失原因,为后续恢复提供依据。结合设备的使用记录、故障现象等信息,深入分析数据丢失的原因,如硬件故障、软件错误、人为操作失误等。确定数据恢复的优先级,保障关键数据优先恢复。根据数据的重要性、时效性等因素,对需要恢复的数据进行排序,确保关键数据能够在最短的时间内得到恢复。

设备检查

检查服务器硬件状态,确保设备正常运行。对服务器的处理器、内存、硬盘、电源等硬件组件进行逐一检查,查看是否存在硬件故障或损坏。测试网络连接稳定性,保证数据传输顺畅。通过网络测试工具,对网络的带宽、延迟、丢包率等指标进行测试,确保网络连接稳定可靠。评估存储设备性能,为恢复方案提供参考。对存储设备的读写速度、容量、可靠性等性能指标进行评估,根据评估结果制定合理的恢复方案。

环境准备

搭建与现有环境匹配的恢复环境。根据现有的服务器操作系统、硬件配置等环境信息,搭建一个与之相同或相似的恢复环境,确保恢复过程的稳定性和兼容性。安装必要的数据恢复软件和工具。选择专业的数据恢复软件和工具,并进行正确的安装和配置,以满足数据恢复的需求。配置服务器参数,满足恢复需求。根据数据恢复的要求,对服务器的各项参数进行调整和优化,如内存分配、磁盘I/O设置等。

数据恢复流程

数据扫描

使用专业工具对存储设备进行全面扫描。采用先进的数据扫描技术,对存储设备的所有扇区进行逐一扫描,确保不遗漏任何数据。定位丢失和损坏的数据块。通过分析扫描结果,准确找出丢失和损坏的数据块的位置和范围。生成数据扫描报告,记录扫描结果。将扫描过程中获取的信息整理成详细的报告,包括数据块的状态、文件系统结构等,为后续的数据修复和提取提供依据。

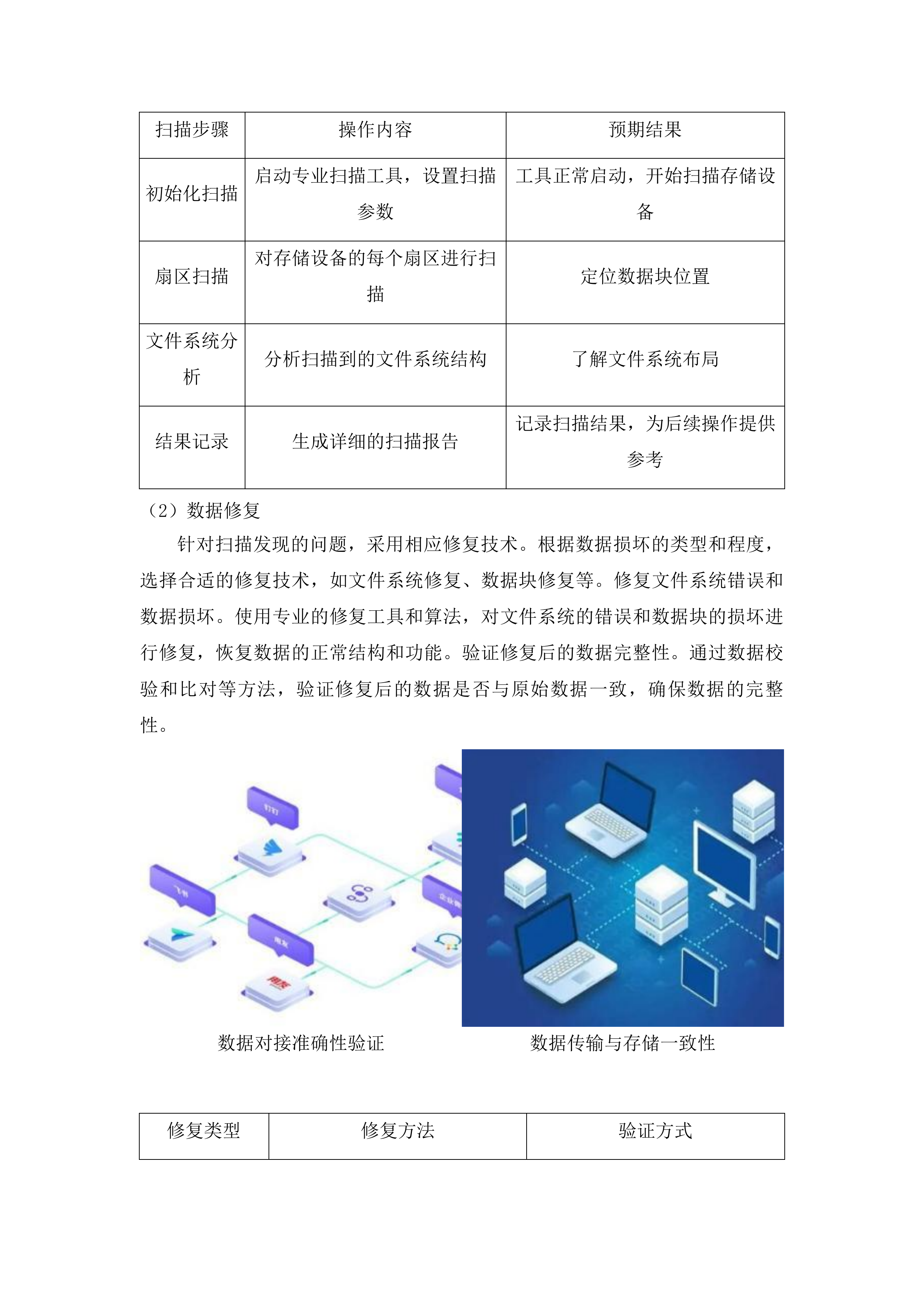

扫描步骤

操作内容

预期结果

初始化扫描

启动专业扫描工具,设置扫描参数

工具正常启动,开始扫描存储设备

扇区扫描

对存储设备的每个扇区进行扫描

定位数据块位置

文件系统分析

分析扫描到的文件系统结构

了解文件系统布局

结果记录

生成详细的扫描报告

记录扫描结果,为后续操作提供参考

数据修复

针对扫描发现的问题,采用相应修复技术。根据数据损坏的类型和程度,选择合适的修复技术,如文件系统修复、数据块修复等。修复文件系统错误和数据损坏。使用专业的修复工具和算法,对文件系统的错误和数据块的损坏进行修复,恢复数据的正常结构和功能。验证修复后的数据完整性。通过数据校验和比对等方法,验证修复后的数据是否与原始数据一致,确保数据的完整性。

数据对接准确性验证

数据传输与存储一致性

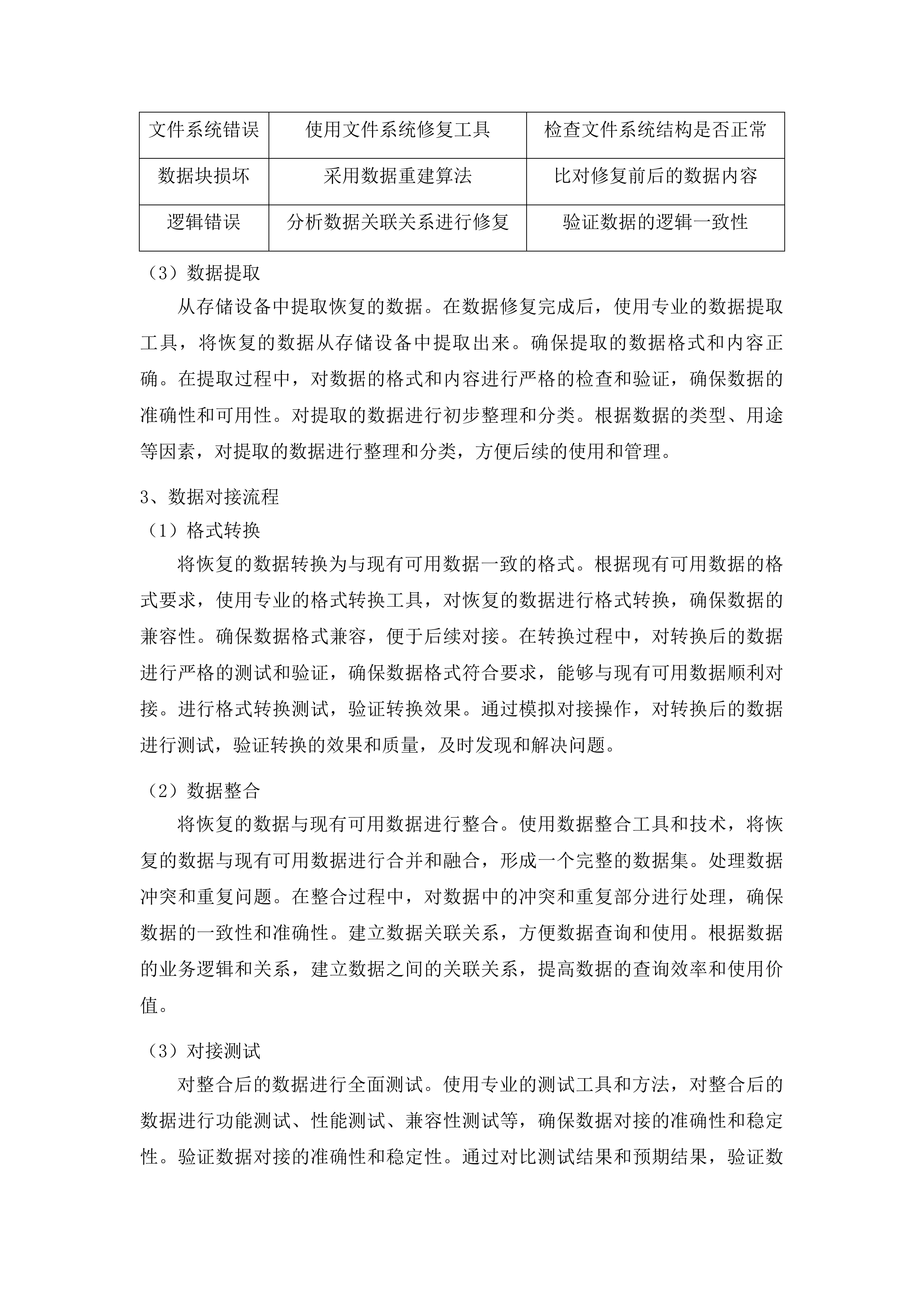

修复类型

修复方法

验证方式

文件系统错误

使用文件系统修复工具

检查文件系统结构是否正常

数据块损坏

采用数据重建算法

比对修复前后的数据内容

逻辑错误

分析数据关联关系进行修复

验证数据的逻辑一致性

数据提取

从存储设备中提取恢复的数据。在数据修复完成后,使用专业的数据提取工具,将恢复的数据从存储设备中提取出来。确保提取的数据格式和内容正确。在提取过程中,对数据的格式和内容进行严格的检查和验证,确保数据的准确性和可用性。对提取的数据进行初步整理和分类。根据数据的类型、用途等因素,对提取的数据进行整理和分类,方便后续的使用和管理。

数据对接流程

格式转换

将恢复的数据转换为与现有可用数据一致的格式。根据现有可用数据的格式要求,使用专业的格式转换工具,对恢复的数据进行格式转换,确保数据的兼容性。确保数据格式兼容,便于后续对接。在转换过程中,对转换后的数据进行严格的测试和验证,确保数据格式符合要求,能够与现有可用数据顺利对接。进行格式转换测试,验证转换效果。通过模拟对接操作,对转换后的数据进行测试,验证转换的效果和质量,及时发现和解决问题。

数据整合

将恢复的数据与现有可用数据进行整合。使用数据整合工具和技术,将恢复的数据与现有可用数据进行合并和融合,形成一个完整的数据集。处理数据冲突和重复问题。在整合过程中,对数据中的冲突和重复部分进行处理,确保数据的一致性和准确性。建立数据关联关系,方便数据查询和使用。根据数据的业务逻辑和关系,建立数据之间的关联关系,提高数据的查询效率和使用价值。

对接测试

对整合后的数据进行全面测试。使用专业的测试工具和方法,对整合后的数据进行功能测试、性能测试、兼容性测试等,确保数据对接的准确性和稳定性。验证数据对接的准确性和稳定性。通过对比测试结果和预期结果,验证数据对接的准确性和稳定性,及时发现和解决对接过程中出现的问题。及时发现和解决对接过程中出现的问题。对测试过程中发现的问题进行及时的分析和处理,采取有效的措施进行修复和优化,确保数据对接的顺利进行。

数据验证机制构建

恢复数据完整性验证

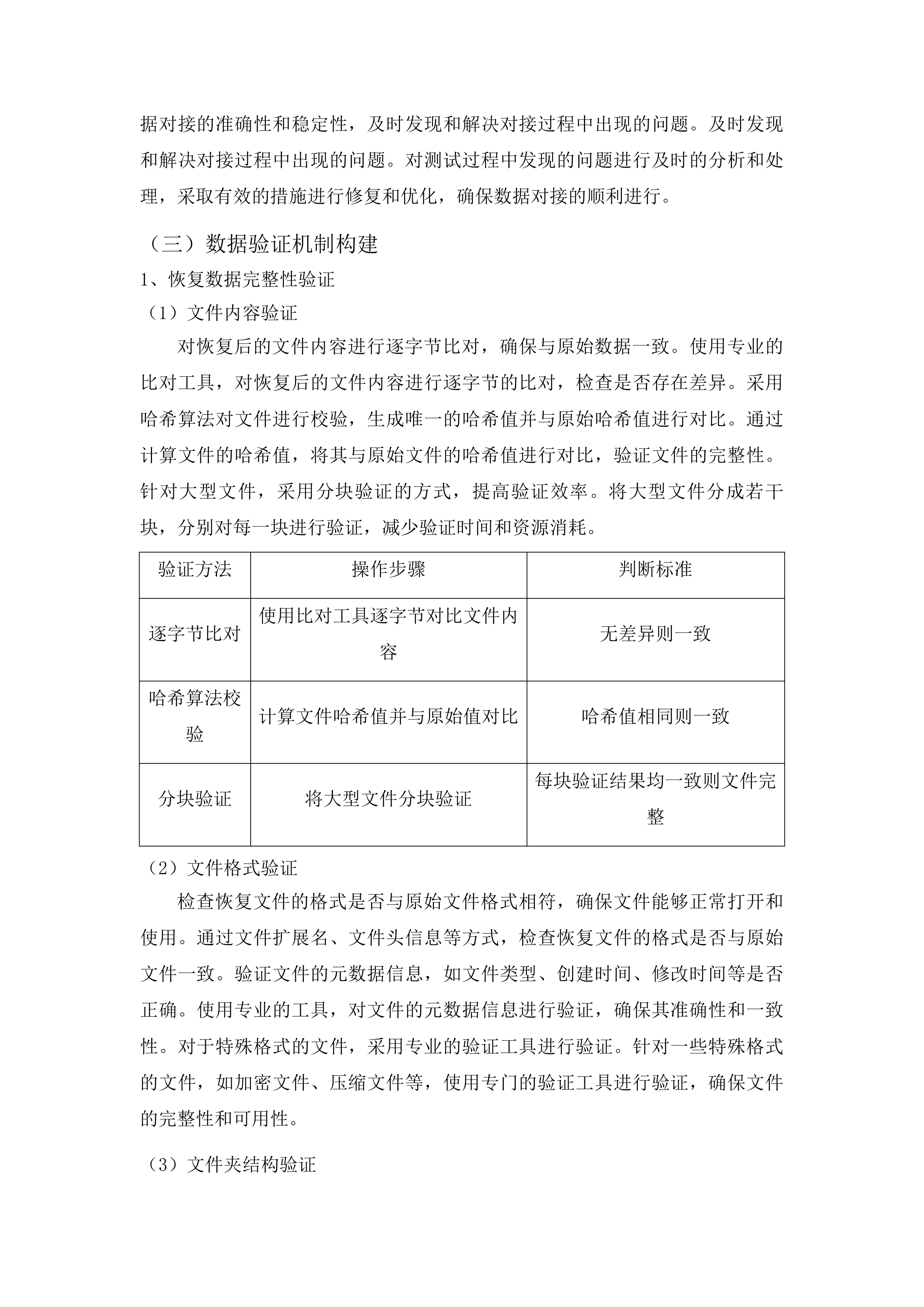

文件内容验证

对恢复后的文件内容进行逐字节比对,确保与原始数据一致。使用专业的比对工具,对恢复后的文件内容进行逐字节的比对,检查是否存在差异。采用哈希算法对文件进行校验,生成唯一的哈希值并与原始哈希值进行对比。通过计算文件的哈希值,将其与原始文件的哈希值进行对比,验证文件的完整性。针对大型文件,采用分块验证的方式,提高验证效率。将大型文件分成若干块,分别对每一块进行验证,减少验证时间和资源消耗。

验证方法

操作步骤

判断标准

逐字节比对

使用比对工具逐字节对比文件内容

无差异则一致

哈希算法校验

计算文件哈希值并与原始值对比

哈希值相同则一致

分块验证

将大型文件分块验证

每块验证结果均一致则文件完整

文件格式验证

检查恢复文件的格式是否与原始文件格式相符,确保文件能够正常打开和使用。通过文件扩展名、文件头信息等方式,检查恢复文件的格式是否与原始文件一致。验证文件的元数据信息,如文件类型、创建时间、修改时间等是否正确。使用专业的工具,对文件的元数据信息进行验证,确保其准确性和一致性。对于特殊格式的文件,采用专业的验证工具进行验证。针对一些特殊格式的文件,如加密文件、压缩文件等,使用专门的验证工具进行验证,确保文件的完整性和可用性。

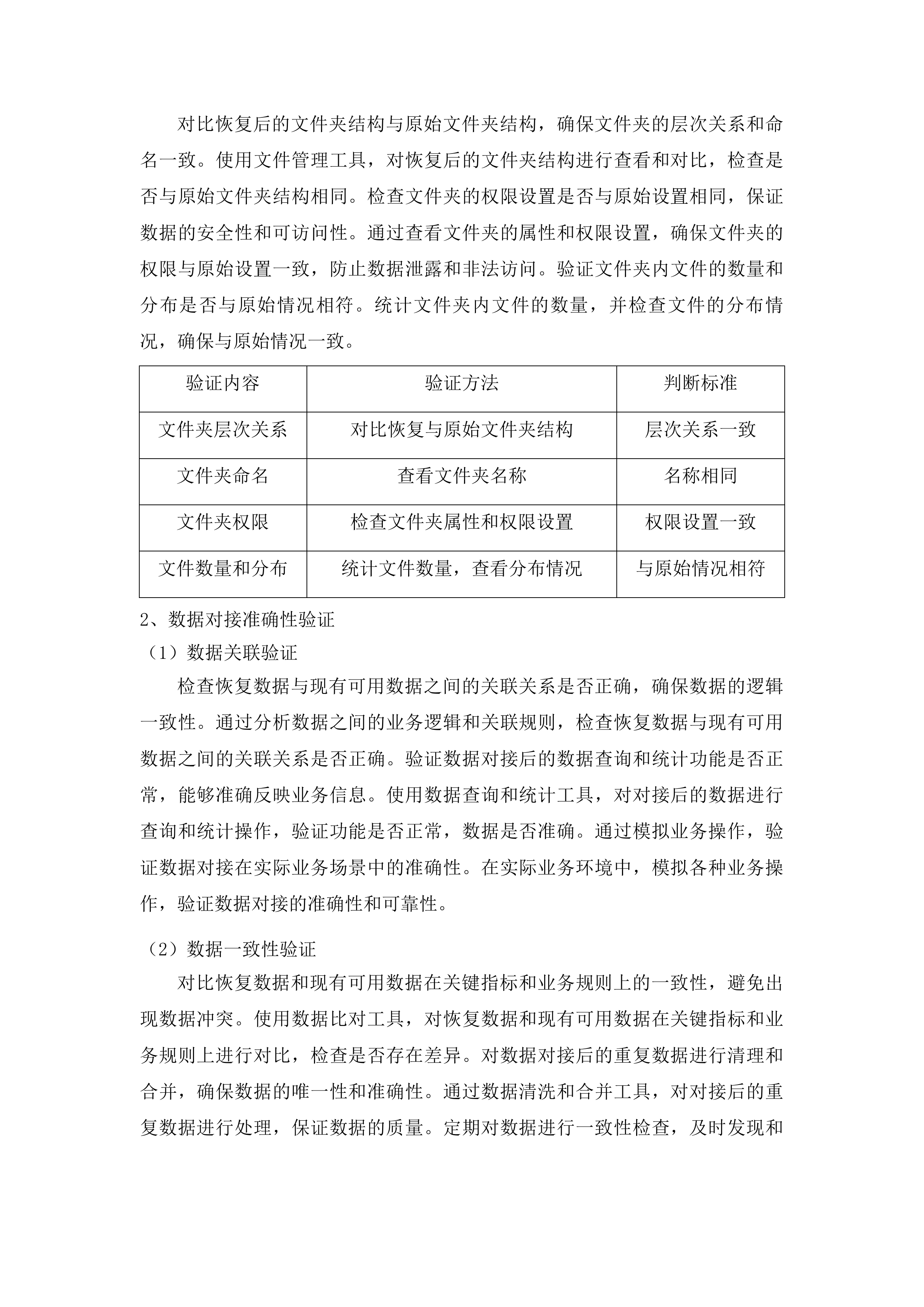

文件夹结构验证

对比恢复后的文件夹结构与原始文件夹结构,确保文件夹的层次关系和命名一致。使用文件管理工具,对恢复后的文件夹结构进行查看和对比,检查是否与原始文件夹结构相同。检查文件夹的权限设置是否与原始设置相同,保证数据的安全性和可访问性。通过查看文件夹的属性和权限设置,确保文件夹的权限与原始设置一致,防止数据泄露和非法访问。验证文件夹内文件的数量和分布是否与原始情况相符。统计文件夹内文件的数量,并检查文件的分布情况,确保与原始情况一致。

验证内容

验证方法

判断标准

文件夹层次关系

对比恢复与原始文件夹结构

层次关系一致

文件夹命名

查看文件夹名称

名称相同

文件夹权限

检查文件夹属性和权限设置

权限设置一致

文件数量和分布

统计文件数量,查看分布情况

与原始情况相符

数据对接准确性验证

数据关联验证

检查恢复数据与现有可用数据之间的关联关系是否正确,确保数据的逻辑一致性。通过分析数据之间的业务逻辑和关联规则,检查恢复数据与现有可用数据之间的关联关系是否正确。验证数据对接后的数据查询和统计功能是否正常,能够准确反映业务信息。使用数据查询和统计工具,对对接后的数据进行查询和统计操作,验证功能是否正常,数据是否准确。通过模拟业务操作,验证数据对接在实际业务场景中的准确性。在实际业务环境中,模拟各种业务操作,验证数据对接的准确性和可靠性。

数据一致性验证

对比恢复数据和现有可用数据在关键指标和业务规则上的一致性,避免出现数据冲突。使用数据比对工具,对恢复数据和现有可用数据在关键指标和业务规则上进行对比,检查是否存在差异。对数据对接后的重复数据进行清理和合并,确保数据的唯一性和准确性。通过数据清洗和合并工具,对对接后的重复数据进行处理,保证数据的质量。定期对数据进行一致性检查,及时发现和解决数据差异问题。建立数据一致性检查机制,定期对数据进行检查,及时发现和处理数据差异问题。

业务功能验证

验证数据对接后业务系统的各项功能是否正常运行,满足业务需求。对业务系统的各项功能进行逐一测试,检查是否能够正常运行,是否满足业务需求。对涉及数据对接的业务流程进行测试,确保业务流程的顺畅和准确。模拟业务流程的执行过程,检查数据对接是否会影响业务流程的正常进行,是否存在数据传输错误等问题。收集用户反馈,及时调整和优化数据对接方案,提高业务系统的使用效率。通过与用户沟通和交流,收集用户对数据对接方案的反馈意见,及时进行调整和优化,提高业务系统的使用效率和用户满意度。

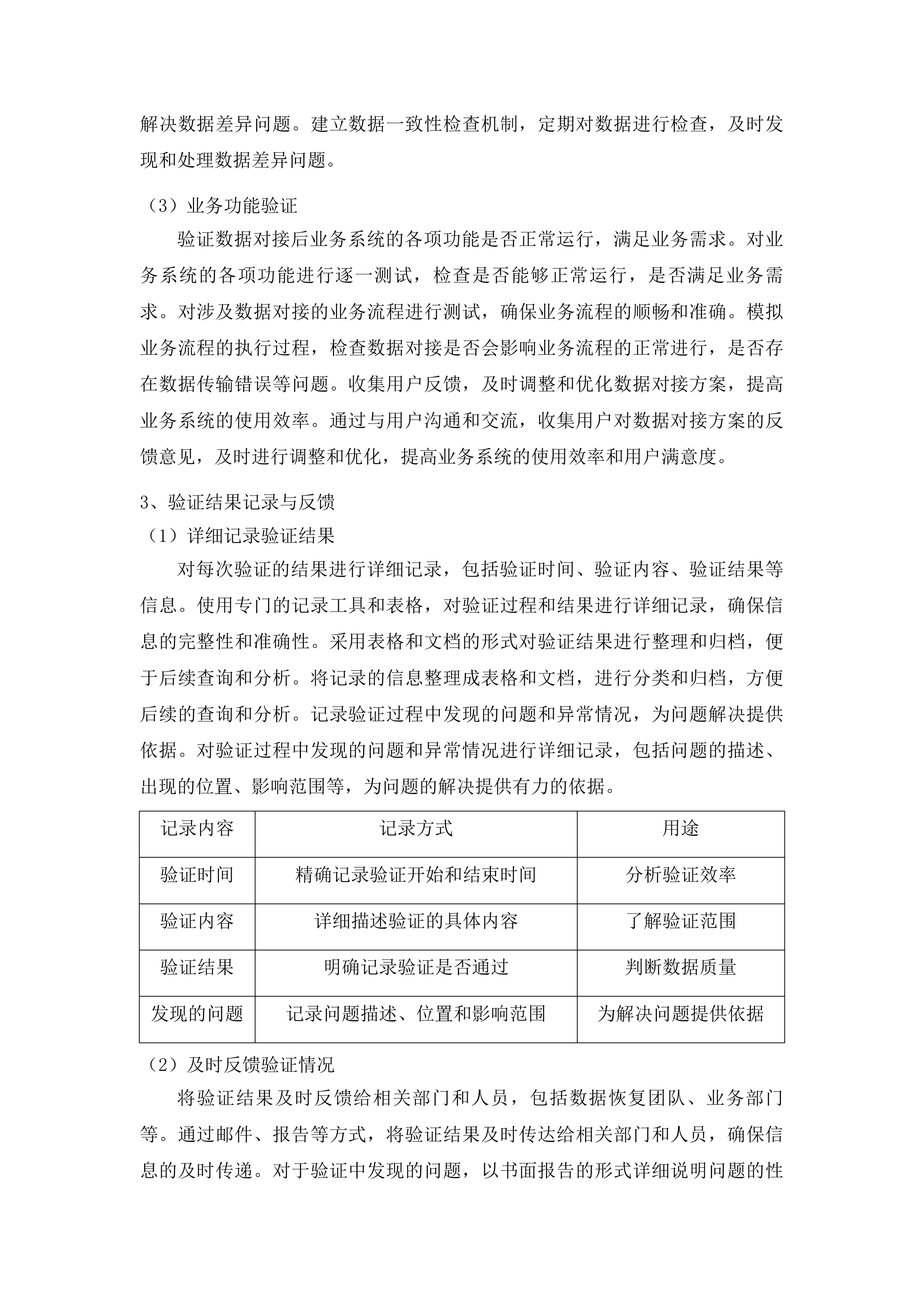

验证结果记录与反馈

详细记录验证结果

对每次验证的结果进行详细记录,包括验证时间、验证内容、验证结果等信息。使用专门的记录工具和表格,对验证过程和结果进行详细记录,确保信息的完整性和准确性。采用表格和文档的形式对验证结果进行整理和归档,便于后续查询和分析。将记录的信息整理成表格和文档,进行分类和归档,方便后续的查询和分析。记录验证过程中发现的问题和异常情况,为问题解决提供依据。对验证过程中发现的问题和异常情况进行详细记录,包括问题的描述、出现的位置、影响范围等,为问题的解决提供有力的依据。

记录内容

记录方式

用途

验证时间

精确记录验证开始和结束时间

分析验证效率

验证内容

详细描述验证的具体内容

了解验证范围

验证结果

明确记录验证是否通过

判断数据质量

发现的问题

记录问题描述、位置和影响范围

为解决问题提供依据

及时反馈验证情况

将验证结果及时反馈给相关部门和人员,包括数据恢复团队、业务部门等。通过邮件、报告等方式,将验证结果及时传达给相关部门和人员,确保信息的及时传递。对于验证中发现的问题,以书面报告的形式详细说明问题的性质、影响范围和解决方案建议。撰写详细的书面报告,对问题进行深入分析,提出合理的解决方案建议,为问题的解决提供指导。定期召开验证结果反馈会议,与相关人员进行沟通和交流,确保问题得到及时解决。组织召开验证结果反馈会议,与相关人员进行面对面的沟通和交流,共同探讨问题的解决方案,确保问题能够及时得到解决。

持续改进验证机制

根据验证结果和反馈意见,对数据验证机制进行持续改进和优化。分析验证过程中存在的不足和问题,总结经验教训,对验证机制进行调整和完善。分析验证过程中存在的不足和问题,制定相应的改进措施和计划。针对验证过程中发现的问题,制定具体的改进措施和计划,明确责任人和时间节点,确保改进工作的顺利进行。引入新的验证技术和方法,提高验证的准确性和效率。关注行业的最新发展动态,引入新的验证技术和方法,不断提高验证的准确性和效率。

原始数据一致性保障

文件名及文件夹对应方案

数据标识与匹配

对原始数据的文件名和文件夹结构进行详细记录,建立数据标识信息库。使用专门的工具和方法,对原始数据的文件名、文件夹名称、文件路径等信息进行详细记录,并存储在数据标识信息库中。在数据恢复过程中,通过数据标识信息对恢复的数据进行匹配和对应,确保文件名和文件夹结构一致。利用数据标识信息库中的信息,对恢复的数据进行匹配和对应,将恢复的数据准确地放置到相应的文件夹中,保证文件名和文件夹结构的一致性。采用智能匹配算法,提高匹配的准确性和效率。运用先进的智能匹配算法,对恢复的数据进行快速、准确的匹配,减少人工干预,提高匹配的效率和准确性。

人力调配

手动调整与确认

对于一些无法自动匹配的数据,安排专业人员进行手动调整和确认。对于那些由于数据损坏、标识信息丢失等原因无法自动匹配的数据,安排具有丰富经验的专业人员进行手动调整和确认。参考原始数据的备份信息和业务逻辑,对文件名和文件夹结构进行修正。根据原始数据的备份信息和业务逻辑,对文件名和文件夹结构进行合理的修正,确保数据的一致性和可用性。在手动调整后,进行再次核对和验证,确保数据的一致性。在手动调整完成后,对调整后的数据进行再次核对和验证,通过比对、校验等方法,确保数据的一致性和准确性。

版本控制与追溯

建立数据版本控制系统,对数据的恢复过程和文件名、文件夹结构的修改进行记录。使用版本控制工具,对数据的恢复过程和文件名、文件夹结构的修改进行详细记录,包括修改的时间、修改的内容、修改的人员等信息。可以随时追溯数据的历史版本,了解数据的变化情况。通过版本控制工具,可以方便地追溯数据的历史版本,查看数据在不同时间点的状态和变化情况,为数据的管理和维护提供有力的支持。在出现问题时,能够快速恢复到之前的正确版本。当数据出现问题时,可以根据版本控制记录,快速恢复到之前的正确版本,减少数据损失和影响。

数据内容一致性保障

数据比对与校验

使用专业的数据比对工具,对恢复的数据和原始数据进行逐字节比对。采用高精度的数据比对工具,对恢复的数据和原始数据进行逐字节的比对,检查是否存在差异。采用哈希算法对数据进行校验,确保数据内容的完整性和一致性。通过计算数据的哈希值,将其与原始数据的哈希值进行对比,验证数据的完整性和一致性。对于大型数据,采用分块比对和校验的方式,提高效率。将大型数据分成若干块,分别对每一块进行比对和校验,减少比对和校验的时间和资源消耗。

数据修复与完善

对于比对过程中发现的差异和错误,及时进行修复和完善。根据比对结果,对发现的差异和错误进行详细分析,找出问题的原因,并采取相应的修复措施。分析数据差异的原因,采取相应的修复措施,如数据补全、错误纠正等。针对不同类型的差异和错误,采用不同的修复措施,如补充缺失的数据、纠正错误的数据等。在修复后,再次进行数据比对和校验,确保数据内容完全一致。在修复完成后,再次对数据进行比对和校验,验证修复的效果,确保数据内容与原始数据完全一致。

数据备份与恢复验证

在数据恢复过程中,对重要的数据进行实时备份,防止数据丢失。使用可靠的备份工具和方法,对重要的数据进行实时备份,确保数据的安全性和可靠性。定期对备份数据进行恢复验证,确保备份数据的可用性和一致性。定期从备份数据中恢复数据,并与原始数据进行比对和校验,验证备份数据的可用性和一致性。通过备份数据的恢复验证,检验数据恢复方案的可靠性。通过对备份数据的恢复验证,评估数据恢复方案的可靠性和有效性,及时发现和解决问题。

备份操作

验证方式

验证周期

实时备份重要数据

恢复备份数据,与原始数据比对校验

每周

定期全量备份

恢复全量备份数据,全面验证

每月

数据传输与存储一致性

传输加密与校验

在数据传输过程中,采用加密技术对数据进行加密处理,确保数据的安全性。使用先进的加密算法,对传输的数据进行加密,防止数据在传输过程中被窃取或篡改。在传输前后对数据进行校验,通过对比校验值确保数据在传输过程中没有发生变化。在数据传输前,计算数据的校验值并记录;在传输后,再次计算数据的校验值并与之前的校验值进行对比,确保数据的完整性。采用可靠的传输协议,保证数据传输的稳定性和完整性。选择稳定、可靠的传输协议,如TCP/IP协议,确保数据在传输过程中不会出现丢包、错误等问题。

存储环境一致性

确保存储恢复数据的环境与原始数据存储环境一致,包括存储设备、文件系统等。对存储设备进行详细的检查和评估,确保其性能和参数与原始存储设备一致;选择与原始文件系统相同的文件系统,保证数据的兼容性和一致性。对存储设备进行定期检查和维护,保证存储设备的性能和稳定性。定期对存储设备进行硬件检查、磁盘清理、数据备份等维护操作,确保存储设备的正常运行。采用冗余存储和备份策略,防止数据因存储设备故障而丢失。采用RAID技术、异地备份等冗余存储和备份策略,提高数据的安全性和可靠性,防止数据因存储设备故障而丢失。

数据更新同步机制

建立数据更新同步机制,当原始数据发生更新时,及时将更新后的数据同步到恢复的数据中。使用数据同步工具和技术,实时监测原始数据的更新情况,并将更新后的数据同步到恢复的数据中。采用增量同步的方式,减少数据同步的工作量和时间。只同步原始数据中发生变化的部分,减少数据传输量和同步时间,提高同步效率。在数据同步过程中,进行数据一致性检查,确保同步后的数据与原始数据一致。在数据同步完成后,对同步后的数据进行比对和校验,确保数据的一致性和准确性。

数据恢复时效控制

恢复时间规划

整体时间安排

根据合同要求,制定数据恢复的整体时间计划,确保在一周内完成数据恢复工作。结合数据量的大小、数据损坏的程度、恢复技术的难度等因素,合理安排各个阶段的时间。将整个恢复过程划分为不同的阶段,明确每个阶段的时间节点和任务目标。将数据恢复过程划分为数据预处理、数据恢复、数据对接、数据验证等阶段,为每个阶段设定明确的时间节点和任务目标。考虑到可能出现的意外情况,预留一定的弹性时间,以应对突发问题。在时间计划中预留一定的弹性时间,用于应对可能出现的硬件故障、软件问题、人员变动等突发情况,确保数据恢复工作能够按时完成。

阶段时间分配

合理分配数据预处理、数据恢复、数据对接等各个阶段的时间,确保每个阶段都有足够的时间完成任务。根据数据量的大小、数据损坏的程度、恢复技术的难度等因素,对各个阶段的时间进行合理分配。根据数据量和复杂程度,对不同阶段的时间进行调整和优化。对于数据量较大、复杂程度较高的情况,适当增加相应阶段的时间;对于数据量较小、复杂程度较低的情况,适当减少相应阶段的时间。在每个阶段结束后,进行时间评估和总结,为后续阶段的时间安排提供参考。在每个阶段结束后,对该阶段的实际用时、任务完成情况等进行评估和总结,分析时间利用效率,为后续阶段的时间安排提供参考。

关键节点设定

确定数据恢复过程中的关键节点,如数据扫描完成、数据修复完成、数据对接完成等。根据数据恢复的流程和任务,确定对整个恢复过程具有重要影响的关键节点。对关键节点进行重点监控和管理,确保按时完成。建立关键节点监控机制,实时跟踪关键节点的进展情况,及时发现和解决问题,确保关键节点能够按时完成。当关键节点出现延误时,及时采取措施进行调整和补救,保证整体进度不受影响。当关键节点出现延误时,分析延误的原因,采取增加资源、优化流程等措施进行调整和补救,确保整体进度不受影响。

资源调配保障

人力调配

安排足够数量和专业技能的人员参与数据恢复工作,确保人员配备满足工作需求。根据数据恢复的任务和难度,合理安排数据恢复工程师、系统管理员、网络工程师等专业人员的数量和职责。根据工作阶段和任务的不同,合理调配人员的工作岗位和职责。在不同的工作阶段,根据任务的特点和需求,合理调配人员的工作岗位和职责,确保人员能够充分发挥自己的专业技能。对人员进行培训和技能提升,提高工作效率和质量。定期组织人员参加培训和学习活动,不断提升人员的专业技能和综合素质,提高工作效率和质量。

设备资源保障

准备充足的服务器等相关软件及硬件设备,确保设备配置参数与现有环境匹配。根据数据恢复的需求,准备足够数量和性能的服务器、存储设备、网络设备等硬件设备,以及数据恢复软件、操作系统等软件设备,确保设备的配置参数与现有环境匹配。对设备进行定期检查和维护,保证设备的正常运行。建立设备定期检查和维护制度,对设备进行硬件检查、软件更新、性能优化等维护操作,确保设备的正常运行。在设备出现故障时,能够及时进行更换和维修,不影响数据恢复进度。准备备用设备,当设备出现故障时,能够及时进行更换;建立快速维修机制,确保设备能够在最短的时间内得到修复,不影响数据恢复进度。

技术资源支持

提供先进的数据恢复技术和工具,确保技术资源能够满足数据恢复的需求。关注行业的最新技术发展动态,引进和应用先进的数据恢复技术和工具,如专业的数据扫描软件、数据修复算法等。与技术研发团队保持密切沟通,及时获取技术支持和解决方案。与数据恢复技术研发团队建立长期稳定的合作关系,及时获取技术支持和解决方案,解决数据恢复过程中遇到的技术难题。不断引入新的技术和方法,提高数据恢复的效率和成功率。定期对技术资源进行评估和更新,不断引入新的技术和方法,提高数据恢复的效率和成功率。

技术资源

获取方式

应用场景

专业数据扫描软件

购买正版软件

数据扫描阶段

数据修复算法

与研发团队合作开发

数据修复阶段

数据加密技术

引进先进技术

数据传输和存储阶段

进度监控与调整

实时进度监控

建立实时进度监控机制,对数据恢复工作的各个环节进行实时跟踪和监控。使用项目管理工具和技术,实时记录数据恢复工作的进展情况,包括任务完成情况、时间进度、资源使用情况等。采用项目管理工具和技术,及时掌握工作进度和任务完成情况。通过项目管理工具,如甘特图、进度报表等,及时了解数据恢复工作的进度和任务完成情况,发现问题及时解决。定期召开进度汇报会议,及时沟通工作进展和存在的问题。定期组织召开进度汇报会议,让项目团队成员汇报工作进展情况,共同讨论和解决存在的问题。

偏差分析与调整

对比实际进度与计划进度,分析进度偏差的原因和影响。定期将实际进度与计划进度进行对比,找出偏差所在,并分析偏差产生的原因和对整个项目的影响。根据偏差情况,及时调整工作计划和资源调配,采取有效的措施加快进度。根据偏差的大小和性质,及时调整工作计划和资源调配,如增加人员、延长工作时间、优化流程等,采取有效的措施加快进度。对调整后的计划进行重新评估和确认,确保计划的可行性和有效性。在调整计划后,对调整后的计划进行重新评估和确认,确保计划的可行性和有效性,避免再次出现进度偏差。

应急响应机制

制定应急响应机制,当出现影响进度的突发事件时,能够迅速采取应对措施。针对可能出现的突发事件,如硬件故障、软件问题、自然灾害等,制定详细的应急响应预案。储备应急资源,如备用设备、应急人员等,确保在紧急情况下能够及时投入使用。储备一定数量的备用设备、应急人员等应急资源,确保在紧急情况下能够及时投入使用,减少突发事件对数据恢复进度的影响。定期对应急响应机制进行演练和评估,提高应急处理能力。定期组织应急响应演练,对应急响应机制进行评估和改进,提高应急处理能力。

文件名文件夹对应方案

文件目录结构重建

原始结构分析

1)对梅河口市中心医院PACS服务器原始数据的文件目录结构展开全面且深入的分析,精确明确各级文件夹的具体分布状况以及它们之间的关联关系。详细梳理文件夹在不同业务模块中的布局,确保对整体结构有清晰的认知。

2)提取关键特征,如文件夹命名规则、子文件夹数量和层级深度等。深入研究命名规则背后的逻辑,确定子文件夹数量与业务规模的关系,以及层级深度对数据管理的影响,为后续重建提供有力依据。

3)梳理不同业务模块对应文件夹的特点和规律。了解各个业务模块的数据存储需求,分析文件夹的使用频率和数据更新情况,以便在重建时更好地满足实际业务需求。

4)确定特殊文件夹的位置和功能,如临时文件夹、备份文件夹等。明确这些特殊文件夹在数据处理过程中的作用,确保在重建时能够准确恢复其功能,保障数据的安全性和可恢复性。

原始结构分析

数据分类整理

1)按照数据的类型、用途和时间等维度对恢复的数据进行细致分类。考虑数据的业务属性,将相关的数据文件归为同一类别,便于后续的处理和管理。例如,将患者信息数据、影像数据等分别归类。

2)将相关的数据文件归为同一类别,便于后续的处理和管理。建立清晰的数据分类体系,提高数据的组织性和可访问性,为数据的进一步分析和利用奠定基础。

3)建立数据分类索引,提高数据查找和访问的效率。通过索引快速定位所需数据,减少查找时间,提高工作效率,确保在紧急情况下能够及时获取关键数据。

4)对分类后的数据进行初步的质量检查,确保数据的完整性和准确性。检查数据是否存在缺失、错误或不一致的情况,及时进行修正和补充,保证数据的质量符合要求。

结构模拟重建

1)根据原始结构分析的结果,模拟重建文件目录结构。严格按照分析得出的文件夹分布、命名规则和层级关系进行重建,确保重建后的结构与原始结构高度一致。

2)创建各级文件夹,并按照原始的命名规则和层级关系进行排列。注重文件夹的命名规范和层级逻辑,使重建后的文件目录结构清晰易懂,便于管理和使用。

3)将分类整理后的数据文件放置到相应的文件夹中。依据数据分类结果,准确无误地将数据文件放置到合适的文件夹中,保证数据的有序存储。

4)对重建后的文件目录结构进行验证和调整,确保与原始结构一致。通过对比原始数据和重建后的结构,检查是否存在差异,及时进行调整和修正,确保重建的准确性和可靠性。

结构模拟重建

文件名映射规则

规则制定依据

1)以原始文件名的特征和规律为主要依据制定映射规则。深入研究原始文件名的构成、命名方式和编码规则,确保映射规则能够准确反映原始文件名的特点。

2)考虑数据的业务属性和使用场景,确保文件名能够准确反映文件的内容。结合医院的业务流程和数据使用需求,使文件名具有明确的业务含义,便于用户识别和使用。

3)遵循行业标准和规范,保证文件名的规范性和可读性。采用统一的命名标准,避免使用特殊字符和不规范的命名方式,提高文件名的通用性和可理解性。

4)结合恢复数据的实际情况,对特殊文件名进行特殊处理。对于一些不符合常规命名规则的文件名,制定专门的处理方法,确保所有文件名都能得到合理映射。

映射关系建立

1)通过对比原始文件名和恢复文件名,建立两者之间的映射关系。采用先进的比对算法,确保映射关系的准确性和完整性。对于复杂的文件名,进行深入分析和处理,确保映射的正确性。

2)采用自动化工具和人工审核相结合的方式,确保映射关系的准确性。利用自动化工具提高工作效率,同时通过人工审核进行精细调整,避免出现错误和遗漏。

3)对复杂的文件名进行解析和转换,确保映射关系的完整性。分析复杂文件名的结构和含义,将其转换为符合映射规则的形式,保证所有文件名都能得到有效映射。

4)建立映射关系数据库,方便后续的查询和管理。将映射关系存储在数据库中,实现对映射关系的集中管理和快速查询,提高工作效率和数据的可维护性。

规则应用验证

1)将建立的文件名映射规则应用到恢复的数据文件上。确保所有恢复的数据文件都能按照规则进行文件名映射,实现数据的准确对应。

2)对应用规则后的文件名进行检查和验证,确保与原始文件名一致。通过与原始数据的对比,检查文件名的准确性,及时发现并纠正映射过程中出现的问题。

3)对验证过程中发现的问题及时进行调整和修正。根据验证结果,分析问题产生的原因,采取相应的措施进行调整和修正,确保文件名映射规则的有效性。

4)进行多次验证和测试,确保文件名映射规则的稳定性和可靠性。通过反复验证和测试,不断优化映射规则,提高其在不同情况下的适应性和准确性。

文件夹层级对应

层级关系识别

1)识别原始数据中文件夹的层级关系,包括父文件夹和子文件夹的关联。通过对文件目录结构的分析,准确确定各级文件夹之间的父子关系,为后续的对应和匹配提供基础。

2)分析不同层级文件夹的功能和作用,明确其在整个文件系统中的地位。了解每个文件夹在数据存储和管理中的具体职责,以及它们之间的协作关系,确保层级对应符合实际业务需求。

3)确定文件夹层级关系的关键特征和标识,便于后续的对应和匹配。提取能够唯一标识文件夹层级关系的特征,如文件夹路径、名称等,提高对应和匹配的准确性。

4)对复杂的文件夹层级关系进行梳理和简化,提高识别的准确性。对于层级结构复杂的文件夹,采用合适的方法进行简化,去除不必要的层级和关联,使层级关系更加清晰明了。

数据匹配对应

1)将恢复的数据文件与重建后的文件夹层级进行匹配对应。依据文件名映射规则和文件夹层级关系,准确地将数据文件放置到正确的文件夹中。

2)根据文件夹的层级关系和文件名映射规则,将数据文件放置到正确的文件夹中。在匹配过程中,充分考虑文件夹的使用权限和数据的访问控制,确保数据的安全性和合规性。

3)对匹配过程中出现的冲突和问题进行解决和调整。对于文件名冲突、文件夹权限不足等问题,及时采取相应的措施进行解决,保证数据匹配的顺利进行。

4)采用自动化工具和人工审核相结合的方式,确保数据匹配的准确性。利用自动化工具提高匹配效率,同时通过人工审核进行质量把关,避免出现错误和遗漏。

对应结果校验

1)对文件夹层级对应结果进行全面校验,确保数据文件的放置位置正确。检查数据文件是否准确地放置在相应的文件夹中,避免出现数据丢失或误放的情况。

2)检查文件夹之间的层级关系是否符合原始结构,避免出现层级错乱的情况。对比重建后的文件夹层级关系与原始结构,确保其一致性和正确性。

3)对校验过程中发现的问题及时进行修正和完善。根据校验结果,分析问题产生的原因,采取相应的措施进行修正,确保文件夹层级对应结果的准确性。

4)进行多次校验和测试,确保文件夹层级对应结果的稳定性和可靠性。通过反复校验和测试,不断优化对应结果,提高其在不同情况下的适应性和准确性。

数据对接计划制定

可用数据整合方案

现有数据梳理规划

数据类型统计

1)全面统计现有可用数据中不同类型的数据,如文本数据、图像数据、数值数据等,为后续的数据处理与分析提供基础信息。

2)深入分析各类数据的占比和特点,明确不同类型数据在整体数据中的重要性和作用,为后续的数据处理提供参考依据。

3)建立详细的数据类型清单,记录每种数据类型的详细信息,包括数据来源、存储位置、数据量等,以便于对数据进行管理和维护。

数据来源追溯

1)精准追溯现有可用数据的来源,确定数据是从哪些系统、设备或业务流程中产生的,明确数据的产生背景和业务逻辑。

2)全面评估数据来源的可靠性和稳定性,分析数据来源的质量和可信度,为数据的整合提供可靠依据。

3)建立完善的数据来源档案,记录每个数据来源的相关信息,包括数据产生时间、数据更新频率、数据使用情况等,以便于对数据来源进行管理和监控。

数据存储定位

1)准确定位现有可用数据的存储位置,包括存储设备、存储系统和存储目录等,明确数据的存储环境和存储方式。

2)全面评估数据存储的安全性和可用性,分析数据存储的风险和隐患,为数据的迁移和整合做好充分准备。

3)建立直观的数据存储地图,展示数据的存储分布情况,包括数据在不同存储设备和存储系统中的分布情况,以及数据之间的关联关系,以便于对数据进行管理和维护。

数据格式统一标准

编码方式规范

1)规定统一的编码方式,如UTF-8等,确保数据在不同系统和设备之间能够正确传输和显示,避免出现乱码等问题。

2)对现有数据的编码方式进行全面检查和转换,确保所有数据都采用统一的编码方式,提高数据的兼容性和可处理性。

3)建立严格的编码方式检查机制,定期对数据的编码进行验证,确保数据的编码方式符合统一标准,避免出现编码不一致的问题。

文件格式整合

1)选择合适的文件格式,如CSV、JSON等,作为统一的数据存储格式,提高数据的兼容性和可处理性。

2)将现有不同格式的文件转换为统一的文件格式,确保所有数据都采用统一的文件格式存储,便于数据的管理和分析。

3)建立高效的文件格式转换工具和流程,确保文件转换的高效性和准确性,减少数据转换过程中的错误和损失。

原文件格式

目标文件格式

转换工具

转换流程

XLSX

CSV

Python脚本

读取XLSX文件,转换为CSV格式,保存文件

XML

JSON

Java程序

解析XML文件,转换为JSON格式,保存文件

字段定义一致

1)统一数据的字段定义,包括字段名称、字段类型、字段长度等,确保数据的一致性和可比性。

2)对现有数据的字段定义进行全面梳理和调整,确保所有数据的字段定义符合统一标准,避免出现字段定义不一致的问题。

3)建立严格的字段定义管理机制,对字段定义的变更进行严格控制,确保字段定义的稳定性和一致性。

数据关联关系建立

关联关系识别

1)运用数据挖掘和分析技术,识别现有可用数据之间的潜在关联关系,发现数据之间的内在联系和规律。

2)根据业务逻辑和数据特征,确定关联关系的类型和强度,明确不同关联关系在业务中的重要性和作用。

3)建立详细的关联关系清单,记录每个关联关系的详细信息,包括关联字段、关联规则、关联强度等,以便于对关联关系进行管理和维护。

关联模型构建

1)选择合适的关联模型,如关系型数据库模型、图数据库模型等,构建数据关联模型,将数据之间的关联关系进行可视化和量化。

2)根据关联关系清单,在关联模型中定义关联字段和关联规则,确保关联模型能够准确反映数据之间的关联关系。

3)对关联模型进行全面测试和优化,确保模型的准确性和性能,提高关联模型在实际业务中的应用效果。

关联关系验证

1)使用专业的数据验证工具和方法,对建立的关联关系进行严格验证,确保关联关系的正确性和可靠性。

2)仔细检查关联数据的一致性和完整性,确保关联关系在数据处理和分析过程中不会出现错误和偏差。

3)对验证过程中发现的问题进行及时处理和修正,确保关联关系的质量和稳定性。

数据接口配置标准

接口功能设计要求

查询功能设计

1)设计灵活的数据查询接口,支持根据不同的条件和参数进行数据查询,满足用户多样化的查询需求。

2)明确规定查询结果的返回格式和排序规则,确保查询结果的一致性和可读性,方便用户对查询结果进行处理和分析。

3)对查询接口进行全面的性能测试和优化,提高查询效率,减少查询响应时间,提升用户体验。

插入功能设计

1)设计安全可靠的数据插入接口,支持将新的数据记录插入到目标数据库或系统中,确保数据的及时更新和补充。

2)定义严格的插入数据的格式和验证规则,确保插入数据的合法性和完整性,避免数据插入过程中出现错误和异常。

3)对插入接口进行全面的异常处理和日志记录,便于问题排查和跟踪,及时发现和解决数据插入过程中出现的问题。

更新功能设计

1)设计高效的数据更新接口,支持对已有数据记录进行修改和更新,确保数据的准确性和及时性。

2)规定明确的更新数据的条件和范围,确保更新操作的准确性和可控性,避免数据更新过程中出现误操作和数据丢失。

3)对更新接口进行全面的数据备份和恢复设计,防止数据丢失,确保数据的安全性和可靠性。

接口性能指标设定

响应时间要求

1)规定数据接口的最大响应时间,确保接口能够及时响应用户的请求,提高用户体验。

2)根据业务的实时性要求,确定不同类型接口的响应时间标准,确保接口能够满足业务的实际需求。

3)对接口进行全面的性能优化,降低响应时间,提高接口的性能和效率。

吞吐量设定

1)设定数据接口的最大吞吐量,即单位时间内能够处理的数据量,确保接口能够满足业务的高并发需求。

2)根据业务的流量预测和系统的处理能力,合理确定吞吐量指标,避免接口出现性能瓶颈。

3)对接口进行全面的压力测试,确保接口在高并发情况下能够稳定运行,提高接口的可靠性和稳定性。

接口类型

最大吞吐量(数据量/单位时间)

压力测试结果

查询接口

1000条/秒

稳定运行

插入接口

500条/秒

稳定运行

并发处理能力

1)确定数据接口的并发处理能力,即同时处理多个请求的能力,确保接口能够满足业务的高并发需求。

2)根据业务的并发访问情况,优化接口的架构和算法,提高并发处理能力,避免接口出现性能瓶颈。

3)对接口进行全面的并发测试,验证接口的并发处理性能,确保接口在高并发情况下能够稳定运行。

接口安全保障措施

身份认证设计

1)设计严格的身份认证机制,对访问数据接口的用户或系统进行身份验证,确保只有合法的用户或系统能够访问接口。

2)采用多种认证方式,如用户名/密码认证、数字证书认证等,提高认证的安全性,防止非法用户或系统访问接口。

3)对认证信息进行加密存储和传输,防止认证信息泄露,确保认证信息的安全性和可靠性。

数据加密处理

1)对数据接口传输的数据进行加密处理,采用对称加密或非对称加密算法,确保数据在传输过程中的保密性和完整性。

2)确保数据在传输过程中的保密性和完整性,防止数据被篡改和窃取,保护数据的安全。

3)对加密密钥进行安全管理,定期更新密钥,确保加密密钥的安全性和可靠性。

访问控制策略

1)制定严格的访问控制策略,对不同用户或系统的访问权限进行控制,确保数据的安全性和可用性。

2)根据用户的角色和职责,分配不同的访问权限,确保不同用户或系统只能访问其有权限访问的数据和功能。

3)对访问控制策略进行定期审查和更新,适应业务变化和安全需求,确保访问控制策略的有效性和可靠性。

数据传输协议选择

协议性能评估指标

传输速度评估

1)全面评估不同传输协议的传输速度,包括最大传输速率、平均传输速率等,了解不同协议在传输速度方面的性能表现。

2)综合考虑数据的大小和传输距离,选择能够满足传输速度要求的协议,确保数据能够快速、高效地传输。

3)对传输协议进行优化,提高传输速度,减少传输延迟,提升数据传输的效率和质量。

可靠性分析

1)深入分析不同传输协议的可靠性,如数据完整性、错误处理能力等,了解不同协议在可靠性方面的性能表现。

2)选择可靠性高的传输协议,确保数据在传输过程中不丢失、不损坏,保障数据的安全性和完整性。

3)对传输协议进行全面的可靠性测试,验证协议的可靠性,确保协议在实际应用中能够稳定运行。

传输协议

数据完整性

错误处理能力

可靠性测试结果

TCP

高

强

稳定运行

UDP

低

弱

存在丢包现象

安全性考量

1)充分考量不同传输协议的安全性,如数据加密、身份认证等,了解不同协议在安全性方面的性能表现。

2)选择安全性强的传输协议,防止数据在传输过程中被窃取和篡改,保护数据的安全。

3)对传输协议进行全面的安全评估和优化,提高协议的安全性,确保协议在实际应用中能够有效防范安全风险。

与现有环境适配性

硬件设备兼容性

1)仔细检查所选传输协议与现有硬件设备的兼容性,如服务器、存储设备、网络设备等,确保硬件设备能够支持所选协议的功能和特性。

2)确保硬件设备支持所选协议的功能和特性,避免出现硬件不兼容的问题,保障数据传输的稳定性和可靠性。

3)对硬件设备进行必要的升级和配置,提高设备的兼容性,确保硬件设备能够与所选传输协议良好配合。

硬件设备

支持的传输协议

兼容性测试结果

服务器

TCP、UDP

兼容

存储设备

TCP

兼容

操作系统适配性

1)全面评估所选传输协议与现有操作系统的适配性,如RedHat7.6等,确保操作系统能够支持所选协议的运行。

2)确保操作系统能够支持所选协议的运行,避免出现系统不兼容的问题,保障数据传输的稳定性和可靠性。

3)对操作系统进行必要的补丁和更新,提高系统的适配性,确保操作系统能够与所选传输协议良好配合。

网络环境适应性

1)深入分析所选传输协议与现有网络环境的适应性,如网络带宽、网络拓扑等,确保协议能够在现有网络环境中正常传输数据。

2)确保协议能够在现有网络环境中正常传输数据,避免出现网络拥塞和丢包等问题,保障数据传输的稳定性和可靠性。

3)对网络环境进行优化和调整,提高网络的适应性,确保网络环境能够与所选传输协议良好配合。

协议可扩展性评估

功能扩展能力

1)全面评估所选传输协议的功能扩展能力,如是否支持新的数据类型、新的业...

梅河口市中心医院服务器数据恢复采购项目投标方案.docx